Cela fait longtemps (depuis la création du site en fait) que je voulais écrire cet article.

Après moults réflexions, plusieurs faux départs et quelques rebondissements, je ma lance enfin! 🙂

Si je voulais attendre une situation « idéale » pour vous proposer cet article, je ne le commencerai jamais, autant le faire maintenant, la perfection n’étant pas de ce monde! ^^

En vérité, vous n’aurez qu’un préambule ici. L’article auquel je pense devra être découper en 3 plus petits, celui ci étant le premier.

En effet, j’ai pas mal de cartes graphiques de marques XFX, mais presque autant de cartes de chez ZOTAC (environ 80 cartes au total au moment ou j’écris ces lignes).

Ces 2 marques ont des styles plutôt cool, une histoire (certes courte) intéressante et ne se superposent pas trop en terme de produit.

Chacune de ces 2 marques aura donc SON article dédié.

Lot Cartes graphiques

Les objectifs de ces 3 articles sont multiples:

° En premier lieu, vous parlez des benchmarks, des jeux, des protocoles de tests ainsi que des constructeurs de GPU (ATI/AMD et nVidia).

° Tester si toutes mes cartes XFX et ZOTAC fonctionnent! ^^ Oui, j’en ai acheté plusieurs que je n’ai jamais testé…

° Pouvoir faire des comparatifs entre cartes et regarder, avec un œil de passionné nostalgique, laquelle est meilleure que l’autre!

° Vérifier si aujourd’hui, une carte datant des années 2000-2010 (entre 10 et 20 ans d’ancienneté en prenant large) peuvent encore être utilisées aujourd’hui et sous quelles conditions.

– Protocoles de tests

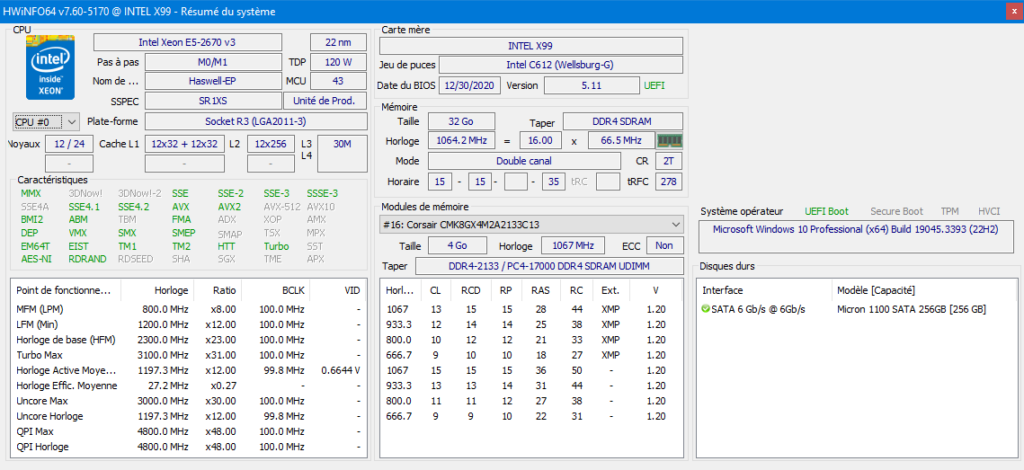

En synthèse, voici les caractéristiques principales du banc de test que l’on va utiliser (l’ancien que vous avez pu voir dans un précédent article a été vendu en occasion):

° Alimentation 🔌: Xilence 700W

° Carte mère: Intel X99 (marque « Kllisre » provenant de AliExpress)

° Processeur: 2 x Intel® Xeon® E5-2669 v3 (2.3Ghz / 3.1Ghz (boost) – 12 Core / 24 Threads – 30Mo cache), des fois reconnu comme E5-2669v3 et des fois comme E5-2670v3, je ne sais pas trop pourquoi, je n’ai pas cherché!

° Carte graphique: en fonction des tests! 🙂

° Mémoire RAM: 32Go DDR4 (2x4Go Corsair + 2x4Go Kingston + 2×8 Go G.Skill) à 2133Mhz

° Stockage: SSD M2 256Go Micron (SATA 6)

° WIFI 📶: Dongle USB Edimax N150 + BT4

° Clavier/Souris ⌨️/🖱️: IBM RT3200

° Ecran: Iiyama G-MASTER (GB2730QSU-B1)

° OS: Windows 10

Combo IBM

Banc de tests

Plusieurs à dire ou à préciser sur cette configuration:

° Sans vous parlez tout de suite des cartes que nous allons tester, la configuration est clairement « overkill » par rapport à la majorité des GPU…

° On pourrait imaginer que les 2.3Ghz des proc soient un peu limite et vous auriez surement raison pour un PC de gamer de 2023. Néanmoins, cela reste correct et le fait qu’il y en ai 2 permet d’avoir 24 coeurs et 48 threads: inutile pour jouer, mais parfait pour miner des Monero! 🙂

° J’ai fait le choix de rester sur un Windows 10 Pro pour permettre aux cartes les plus anciennes d’avoir un pilote fonctionnel.

° Je pourrai n’avoir que 16Go de mémoire vive avec les G.Skill et passer à 2400Mhz, mais je ne pense pas que cela change grand chose.

° On ne mesurera pas les performances de chargement donc le M2 Micron suffira

° Le Wifi en 802.11n suffira, c’est seulement pour télécharger les mises à jour.

° Le kit Clavier/Souris est une récupération d’une baie de serveurs. Inutile de penser à jouer avec ces éléments, ils ont été créé pour se mettre dans un rack et faire de l’administration! Mais cela reste bien pratique d’avoir un « tout-en-un ».

Le truc un peu nul, c’est qu’il n’y a pas de pavé numérique. Cela prend, certes moins de place, mais c’est pénible pour taper des adresses IP par exemple. Il n’est pas impossible que je branche un autre couple clavier/souris si il me prend l’envie de jouer un peu quand même/

° Vous aurez peut-être reconnu mon écran que j’avais dans ma config perso (Review #4). Il est depuis plusieurs mois avec mon bans de test car je me suis offert un écran 144Hz incurvé 27″ de chez Koorui! 🙂

° Le fait que les ventilateurs expulsent l’air de droite à gauche n’est pas à soucis en soit si je n’avais qu’un seul processeur. Mais ici, l’air chaud du premier est utilisé pour refroidir le second! J’ai un soucis de place ici, les ventirads seront changés lors des tests.

HWinfo

— Les benchmarks graphiques

Avant de parler des différents logiciels, sachez qu’autant que possible, j’essaierai de calibrer les mêmes paramètres sur les Benchmarks afin de pouvoir comparer ce qui est comparable.

En effet, je n’ai pas réussi à trouver l’information précisément, mais je pense que le score donné à chaque test dépend, en partie en tout cas, des paramètres que l’on donne au logiciel.

Par exemple, sur un 3DMark06, avec une configuration matériel parfaitement identique, si je lance le logiciel avec des paramètres différents (niveaux de détails, résolution, etc.), je sais que le score sera différent! Ce qui n’est pas très pratique pour faire des comparaisons…

De plus, les scores ne sont pas « linéaires »: ce que je veux dire par là c’est qu’une carte graphique qui aurait un score de 9000 et une autre de 18000, cette dernière ne sera pas 2 fois plus « puissante » que la première.

Il faudrait même pouvoir définir ce que veux dire « puissante » pour une carte graphique (fréquence, mémoire, instructions, etc.). Mais cela sera le sujet d’un ou deux articles dédiés plus ou moins à ce sujet! 😉

Bref, le calcul de ces scores est assez « obscures », d’où l’importance de garder les mêmes paramètres autant que possible pour tenter des comparaisons, mêmes arbitraires.

Ce que je peux vous dire, c’est que s’il existe un « template » de tests du style « Basic », « Medium » et « Extreme », je les utiliserai.

A défaut, je fixerai la profondeur de couleurs à 32 bits, les graphismes au maximum et je bougerai uniquement les résolutions, en utilisant des références du format 16/9 qui ont été utilisé à travers les années: 1280×720 (HD), 1920×1080 (FHD) et 2560×1440 (QHD), je ne toucherai donc pas aux différents détails de Anti-Aliasing ou autre.

J’aurai pu ajouter le format 1024×768 (format 4/3) mais la différence du nombre de pixels à afficher avec le 720p n’est pas énorme (1024×768 = 786432 pixels et 1280×720 = 921600 pixels). Je ne peux pas tester la résolution 3840×2160 (UHD) car je n’ai pas d’écran compatible disponible.

Comme je parle de pixels, je vous rappelle que le Full High Definition (FHD) qui a une résolution de 1920×1080 affiche est aussi appelé 2K (car proche de 1920). Alors que la Ultra High Definition (UHD) qui a comme résolution 3840×2160 est aussi appelé 4K (car proche de 3840).

— Madonion / Futuremark

Ce n’est pas la première fois que vous croisez ces logiciels sur le site, mais je n’en ai jamais vraiment parlé.

Initialement connu sous le nom de Madonion, l’entreprise Futuremark est sans aucun doute incontournable lorsqu’il s’agit de « benchmarker » (tester) les configurations (graphiques) des ordinateurs.

Très (re)connu pour ces logiciels aux noms évocateurs (3DMark), Futuremark propose/proposait aussi des logiciels pour tester/stresser l’ensemble de la machine (PCMark), mais aussi la qualité vidéo, la fiabilité de la batterie, etc.

Bien entendu, je me suis focaliser sur les benchmarks graphiques: 3DMark. Au fur et à mesure de la sortie de nouvelles versions, chaque logiciel pesait de plus en plus lourd et permettait de tester des cartes graphiques de plus en plus puissantes.

Malheureusement, je n’ai pas pu installer le premier et célèbre 3DMark99 qui utilisait l’API DirectX en version 6, étant donné que le soft n’est plus compatible sur Windows 10 (et déjà plus compatible sur Windows depuis XP).

J’espère pourvoir un jour faire une Review d’une machine encore un peu plus ancienne que la Review #1 avec une carte Voodoo par exemple! 🙂 On pourra alors faire tourner ce 3DMark99.

Notez que sur leur site, dans la section « Legacy », Futuremark propose TOUS les logiciels en téléchargement légale et gratuit (avec un clé d’activation à chaque fois).

Seules les dernières versions ne sont disponibles qu’à la vente.

MadOnion

Futuremark

Voici ci dessous, les rapides descriptions (en anglais) de chaque logiciel que l’on peut retrouver sur le site Internet.

° 3DMark2000: This is a DirectX 7 benchmark released under the MadOnion.com brand. The Helicopter and Adventure tests feature hardware transform and lighting, bump mapping, and LOD scaling.

° 3DMark2001 SE: 3DMark2001 is a DirectX 8 benchmark. The Car Chase, Dragothic, Lobby and Nature tests feature vertex and pixel shaders and full scene anti-aliasing. 2001 SE added DirectX 8.1 support.

° 3DMark03: 3DMark03 uses a DirectX 9 engine created by Futuremark. It was the first 3DMark to include CPU tests. The graphics tests are Wings of Fury, Battle of Proxycon, Troll’s Lair and Mother Nature.

° 3DMark05: With support for DirectX 9.0c and up to 2 million polygons on screen, 3DMark05 raised the bar for gaming benchmarks. Game tests include Return to Proxycon, Firefly Forest and Canyon Flight.

° 3DMark06: 3DMark06 builds on 3DMark05 with DirectX 9 Shader Model 3.0 effects and new CPU tests using PhysX. The graphics tests are Return to Proxycon, Firefly Forest, Canyon Flight and Deep Freeze.

° 3DMark Vantage: 3DMark Vantage is a DirectX 10 video card benchmark test for Windows Vista. It includes the Jane Nash and New Calico graphics tests, an AI test, a physics test and six feature tests.

° 3DMark 11: 3DMark 11 is a DirectX 11 gaming benchmark for Windows 7. It includes the Deep Sea and High Temple graphics tests, a Physics test, and a Combined test, and a selection of quality presets.

° 3DMark: La particularité de cette version sortie en 2016 c’est qu’elle se met à jour réguliérement en intégrant de nouveaux tests et des nouvelles technologies.

C’est pour cette raison qu’il n’y a plus de référence à la date dans le nom et qu’il existe depuis maintenant 6 ans.

C’est aussi la seule version que j’ai en version « gratuite », donc sans les fonctionnalités avancées et sans possibilités de bouger les paramètres.

J’utiliserai cependant les différents tests possibles intégrés à cette version gratuite.

— Unigine Benachmark

On passe ici chez un autre éditeur de logiciel: Unigine Benchmark. Un peu moins connu, certes, mais proposant 5 logiciels très qualitatifs! Je connais un peu moins car je ne les ai découvert que plutot récemment et j’ai un peu moins de choses à raconter sur ces logiciels… lol

Mais je vous invite tout de même à aller sur leur site et à télécharger les versions gratuites des benchmarks qui sont très complets et très agréables à regarder!

Une différence notable à noter quand même par rapport à 3DMark, c’est que ce n’est PAS une suite de test avec plusieurs écrans différents à chaque fois.

C’est ici un seul et long test, sur le même thématique, sur le même espace graphique, sans coupure ni temps de chargement entre 2 écrans.

Unigine

Comme précédemment, voici ci dessous, les rapides descriptions (en anglais) de chaque logiciel que l’on peut retrouver sur le site Internet.

° Sanctuary 2007: A gothic chapel with sorrowful statues stand in solemn stillness lit by the trembling light of torches.

° Tropics 2008: The benchmark depicts tropical paradise: waves of the infinite ocean leisurely rolls over the sun-splashed shores of lagoon islands.

° Heaven 2009: Magical steampunk world of shiny brass, wood and gears. Nested on flying islands, a tiny village with its cozy, sun-heated cobblestone street is guarded by a majestic dragon.

° Valley 2013: The forest-covered valley surrounded by vast mountains amazes with its scale from a bird’s-eye view and is extremely detailed down to every leaf and flower petal.

° Superposition 2017: A lone professor performs dangerous experiments in an abandoned classroom, day in and day out. Obsessed with inventions and discoveries beyond the wildest dreams, he strives to prove his ideas in quantum theory.

— Geeks3D FurMark

Un peu moins connu mais cependant très utilisé et depuis longtemps, ce benchmark spécialité sur OpenGL existe depuis plus de 15 ans! Comme les autres logiciels, il a des « template » intégrés et la possibilité de pousser les résultats sur leur site WEB pour comparer avec les autres utilisateurs.

Comme les logiciels de chez Unigine, FurMark propose un seul test qui va stresser et faire chauffer la carte pendant quelques secondes/minutes. Ce n’est pas spécialement beau à regarder mais on peut noter l’évolution de la température en temps réel.

On trouve cette phrase sur la page d’accueil du site: « FurMark is a lightweight but very intensive graphics card / GPU stress test on Windows platform. It’s a quick OpenGL benchmark as well (online scores). FurMark is simple to use and is free. »

FurMark

— Les jeux

Vous remarquerez dans les articles suivants qu’il ne sera pas nécessaire ou pertinent d’installer des jeux trop récents puisque les cartes les plus anciennes que j’ai datent de 2003. Rares sont les cartes qui sont entre 2013 et 2021.

Je vais donc me concentrer ici sur:

° Minecraft 1.19.1

° Quake III Arena 1.32

° Doom (avec Moteur GZDoom avec quelques mods dont Brutal Doom, Voyez mon article à ce sujet pour plus d’infos > de la HD, de la parallaxe, du gore, de nouveaux sprites, plus rapides, etc.)

° Heretic et Hexen (avec Moteur GZdoom et des mods HD qui déchirent!)

° TrackMania Nation Forever 2.11.26

° Warcraft III The Frozen Throne 1.26a

° Titan Quest Anniversary Edition 2.10.2

De plus, je ne voulais pas installer des jeux qui nécessitent des comptes en ligne. J’ai donc un peu galérer à trouver des jeux intéressants sans compte obligatoire: c’est la principale raison qui fait que vous ne verrez pas de Fortnite, Rocket League, Valorant, WoW, League of Legend, etc.

A la différence des benchmarks, il s’agira ici de trouver la bonne configuration, les bons paramètres graphiques afin d’avoir la meilleure jouabilité avec des graphismes au plus haut possible.

Cela sous entend donc que je ne vais pas fixer les configurations graphiques, mais que je vais plutôt fixer des objectifs de FPS (Frame Per Second, autrement dit des Images Par Secondes): 30 et 60.

Ces 2 paliers me semblent pertinents pour des cartes de cette décennie. Inutile de monter à plus de 60 FPS puisque les écrans plats ne dépassaient pas à l’époque (ou rarement) les 60Hz (beaucoup d’écrans Dell avait un fréquence native de 75Hz, mais c’étaient des écrans professionnels, pour les entreprises principalement).

Les gamers gardaient d’ailleurs les énormes écrans CRT afin de pouvoir monter à des fréquences bien plus élevées.

Je considère (et c’est purement personnel et arbitraire), qu’en dessous de 30 FPS, la jouabilité est trop largement sacrifiée et cela n’est plus agréable à jouer (c’est discutable bien entendu et dépendra du style de jeu dont on parle).

Je vois d’ici les ProGamerz, puristes et autres joueurs riches qui me diront qu’en dessous de 144Hz, cela n’est pas possible de jouer à Fortnite, League of Legend, Rocket League ou d’autres jeux compétitifs en multijoueur…

Et je comprends leur point de vue! Néanmoins, on teste ici d’anciennes cartes, qui ne sont pas de la même époque et les usages d’avant ne sont plus ceux d’aujourd’hui.

Donc, la réponse à la question: « Puis-je jouer avec une carte de 15 ans dans d’aussi bonnes conditions qu’une 4090 RTX Ti? » est bien évidemment, et sans surprise, NON!

– Quelques infos sur les constructeurs de GPU

— nvidia

NVIDIA

On se limitera aux cartes GeForce ici, même si nvidia a eut quelques cartes avant (Vanta, TNT, etc.). Nous ne parlerons pas non plus des cartes « pro » ayant une appellation « Quadro ». L’idée n’est pas de faire un historique complet non plus!

Pour simplifier les choses au maximum, il faut considérer que l’on met de coté les quelques cartes anecdotiques qui ne respectent pas les règles, mettre aussi de coté les constructeur qui décidaient d’appeler autrement les cartes et il faut découper les cartes nvidia en 4 catégories chronologiques:

° de la GeForce 256 (première génération) jusqu’aux GeForce 4

° des GeForce FX aux GeForce 9000

° des GeForce GTX 200 jusqu’aux GeForce GTX 1000 (incluant les cartes TITAN)

° Les dernières GeForce RTX 2000, 3000 et plus récemment 4000

Les GeForce 2 et 3 n’avaient pas beaucoup de cartes différentes: GTS (moyen/haut de gamme), Ultra (Haut de Gamme) et l’apparition des Ti (pour Titanium, du haut de gamme aussi). Des GF 2 à GF 4, les Ti étaient un niveau de gamme à part entière.

Le type « MX » n’est arrivé qu’avec les GF 4 qui a voulu décliné des cartes moyen de gamme. Des GF 2 ont bénéficié de cette appellation à ce moment là.

La gamme FX est la 5ème génération des GF, elle voit apparaitre le port PCI express. Les dernières cartes en AGP étant les cartes de 7ème génération.

Elles officialisent le chiffre des milliers comme information sur la génération, puis le chiffre des centaines pour la gamme (Exemple: GeForce FX 5700 pour une carte de 5ème génération de milieu/haut de gamme pour le 700).

Petite information intéressante: suite au rachat de la firme 3DFX (avec les légendaires cartes Voodoo), nvidia a acquis la bas de la technologie SLI et c’est à partir des générations 6 qu’il devenait possible de lier 2 cartes ensemble pour augmenter la puissance!

A partir de ce moment là de l’histoire, les premières cartes de chaque génération qui sortaient étaient souvent une gamme x800 (où x représente la génération), donc une carte haut de gamme.

Cela laissait la possibilité de sortir une x900 si jamais c’était possible! ^^ On avait aussi ces termes, dans l’ordre de puissance, pour désigner la sous-gamme: GS, GT, GTS, GTX, XT (pour eXTreme).

On pouvait donc avoir des: GeForce FX 5900 XT, GeForce 6600 GT, GeForce 7800 GTX, GeForce 8800 GTS, GeForce 9600 GS, etc. Étonnamment, je n’ai pas souvenir de gamme « Ti » durant cette période (mais peut être que je me trompe ou que j’ai simplement oublié).

A partir des GeForce 200 GTX, On repart sur une nouvelle dénomination avec le terme GTX qui accompagne systématiquement la marque GeForce.

On repart sur des centaines pour désigner la génération et les dizaines pour identifier les gammes, on ira même jusqu’aux unités (0 ou 5), pour la sous-gamme.

Seules les cartes bas de gammes pouvaient perdre le X de GTX pour désigner le fait que ce n’était pas une carte destinée au gaming.

Vous aurez compris que c’est le même processus de nommage pour les dernières GTX en 1000 (où il faut considérer le 10 comme les centaines. Après tout, 10 x 100, cela fait bien 1000! ^^).

Durant les générations GTX, on retrouvera l’apparition de noms Ti, pour préciser que c’est la même carte, mais « boostée » (fréquence plus grande? mémoire plus importante? overcloking d’usine? etc.).

Pas grand chose qui change pour les RTX, un peu la même chose que les GTX mais en mieux (pour info le RT veut dire Ray-Tracing). On aura seulement l’apparition des gammes « Super » qui se positionnent entre la gamme classique et le haut de gamme Ti.

Pour plus de détails, je vous renvoie sur la page du wiki: https://fr.wikipedia.org/wiki/GeForce

— ATI/AMD

ATi AMD

Idem pour ATI/AMD, rapides explications pour reconnaitre les noms des cartes. Je suis un peu moins calé en cartes ATI/ADM car je ne pense pas en avoir déjà eut véritablement dans mes PC perso.

Historiquement, ATI était une marque fondée par un chinois immigré au Canada (c’est la raison de la couleur blanche et rouge du logo? Nul ne le sait…) et c’est en 2006 qu’AMD (le fabricant de processeur) a racheté la marque pour finalement continuer à vendre des GPU sous le nom d’AMD.

Étant donné que ce sont très majoritairement des cartes de la générations Radeon HD, il reste à comprendre ce que veux dire les chiffres.

Prenons par exemple, une Radeon HD 5870:

° 5 signifie la génération de cartes, donc les changements sont majeures: les GPU différents, les instructions, etc.

° 8 donne une information sur la gamme de la série 5, ici on est sur une carte plutôt haut de gamme. On a donc des changements qui peuvent faire une différence mais sans être majeure.

° 7 définira ensuite la finition de la carte. les changements sont mineures. On peut donc imaginer que dans les cartes 58xx, il doit y avoir les 50, 70 ou 80 qui fera changer quelques détails, par exemple certaines fréquences

La gamme des Radeon Rx succède aux Radeon HD avec l’utilisation des chiffres de la centaines pour définir la génération puis les dizaines pour la gamme.

Petite variante, après les Rx 200, 300, 400 puis 500, on passe directement à 5000 et 6000! Ils sont fous ces ATI/AMD… De plus, seules les cartes des séries Rx 200 et 300 ont vu leur « x » changer en 7 et 9 pour désigner la gamme. Alors pourquoi 7 et 9? Nul ne le sait…

J’aurai pu parler, dans l’ordre chronologique, des générations précédentes des HD: ATI Rage, ATI Radeon, ATI Radeon X, etc. Mais je suis un peu moins calé en cartes ATI/AMD et je ne veux pas raconté de bêtises! J’ai aussi peu de cartes de ces générations sous la marque XFX…

Pour plus d’infos sur les gammes Radeon, go wiki: https://fr.wikipedia.org/wiki/Radeon

– Conclusion

Bien entendu, j’aurai pu faire un article entier sur chacun des constructeurs, tant il y a des choses incroyables à raconter pour un vieux passionné comme moi qui a connu les premières cartes graphiques dans sa jeunesse et qui baigne encore dedans à son âge! ^^ Mais Cela aurait été trop long et je n’aurai que paraphraser ce qui existe déjà sur Internet, je n’aurai rajouter que quelques anecdotes insignifiantes…

Pour finir, bah… il n’y a pas vraiment de conclusion à faire! Par contre je suis maintenant prêt à me lancer dans les longues heures de tests de toutes les cartes XFX et ZOTAC!

2 articles sortiront indépendamment et peut être pas l’un juste derrière l’autre… Je verrai bien!

Je vais réfléchir à la forme que pourra avoir les tests finaux: fichier Excel disponible et téléchargeable par exemple? Je vais voir…

En espérant vous avoir appris quelques trucs et j’ai hâte de vous retrouver pour vous présenter ma petite collection! 🙂

A très vite j’espère! 🙂